Вот уже более шестнадцати лет у каждого пользователя есть хорошая возможность внести посильный вклад в развитие науки. Не нужны денежные пожертвования и даже профессиональный интерес к выбранному предмету исследований. Имеет значение лишь то, какими чертами характера обладает человек и насколько современные компьютеры есть в его распоряжении. При удачном сочетании этих факторов появляются надёжные узлы сетей распределённых вычислений – одного из самых мощных инструментов компьютерной обработки данных.

Благодаря совместным усилиям обычных пользователей удалось сделать множество значимых открытий. Только за последние три года они отыскали 53 пульсара, причём последние семь нашлись совсем недавно – в конце августа 2012 г. Результаты выполненных исследований используются при разработке лекарственных препаратов для лечения сахарного диабета второго типа, болезней Альцгеймера и Паркинсона, других тяжёлых заболеваний. По материалам выполненных работ опубликованы сотни научных статей.

Суперкомпьютеры и распределённые сети

Мощные суперкомпьютеры – это капля в море. Машин, которые представляют собой предмет гордости целых стран и занимают первые строчки рейтинга TOP 500, не так уж много, и на всех их не хватает. Чтобы получить доступ к суперкомпьютеру, требуется сначала обосновать необходимость выбранной задачи, а потом, если доводы оказались убедительными, дождаться очереди и успеть оптимизировать код для выполнения на своеобразной суперкомпьютерной архитектуре.

Последовательные вычисления в распределённых системах выполняются с учётом одновременного решения многих задач. Особенностью распределённых многопроцессорных вычислительных систем, в отличие от локальных суперкомпьютеров , является возможность неограниченного наращивания производительности за счёт масштабирования. :550 Слабосвязанные, гетерогенные вычислительные системы с высокой степенью распределения выделяют в отдельный класс распределённых систем - грид .

История [ | ]

Работы по распределённым вычислениям с весьма прикладной целью - для военных нужд, а именно автоматизации процессов секретной связи и обработки разведывательной информации, велись интенсивно в США с 1960-х гг. Разработкой технологий распределённых вычислений и созданием распределённых информационных систем в Соединённых Штатах по заказу Агентства по перспективным оборонным научно-исследовательским разработкам США , видов вооружённых сил и служб (агентств) в структуре Министерства обороны США занимались исследовательские подразделения компаний и университетов:

В 1973 году Джон Шох и Джон Хапп из калифорнийского научно-исследовательского центра Xerox PARC написали программу, которая по ночам запускалась в локальную сеть PARC и заставляла работающие компьютеры выполнять вычисления .

В 1978 году советский математик Виктор Глушков работал над проблемой макроконвейерных распределённых вычислений. Он предложил ряд принципов распределения работы между процессорами . :320 На базе этих принципов им была разработана ЭВМ ЕС-2701 .

В январе 1996 года стартовал проект GIMPS по поиску простых чисел Мерсенна , также используя компьютеры простых пользователей как добровольную вычислительную сеть.

28 января 1997 года стартовал конкурс RSA Data Security на решение задачи взлома методом простого перебора 56-битного ключа шифрования информации RC5 . Благодаря хорошей технической и организационной подготовке проект, организованный некоммерческим сообществом distributed.net , быстро получил широкую известность .

Распределённые операционные системы [ | ]

Распределённая ОС, динамически и автоматически распределяя работы по различным машинам системы для обработки, заставляет набор сетевых машин обрабатывать информацию параллельно. Пользователь распределённой ОС, вообще говоря, не имеет сведений о том, на какой машине выполняется его работа.

Распределённая ОС существует как единая операционная система в масштабах вычислительной системы. Каждый компьютер сети, работающей под управлением распределённой ОС, выполняет часть функций этой глобальной ОС. Распределённая ОС объединяет все компьютеры сети в том смысле, что они работают в тесной кооперации друг с другом для эффективного использования всех ресурсов компьютерной сети.

В результате сетевая ОС может рассматриваться как набор операционных систем отдельных компьютеров, составляющих сеть. На разных компьютерах сети могут выполняться одинаковые или разные ОС. Например, на всех компьютерах сети может работать одна и та же ОС UNIX . Более реалистичным вариантом является сеть, в которой работают разные ОС, например, часть компьютеров работает под управлением UNIX, часть - под управлением NetWare, а остальные - под управлением Windows NT и Windows 98 . Все эти операционные системы функционируют независимо друг от друга в том смысле, что каждая из них принимает независимые решения о создании и завершении своих собственных процессов и управлении локальными ресурсами. Но в любом случае операционные системы компьютеров, работающих в сети, должны включать взаимно согласованный набор коммуникационных протоколов для организации взаимодействия процессов, выполняющихся на разных компьютерах сети, и разделения ресурсов этих компьютеров между пользователями сети.

Если операционная система отдельного компьютера позволяет ему работать в сети, и может предоставлять свои ресурсы в общее пользование и/или использовать ресурсы других компьютеров сети, то такая операционная система отдельного компьютера также называется сетевой ОС.

Таким образом, термин «сетевая операционная система» используется в двух значениях: как совокупность ОС всех компьютеров сети и как операционная система отдельного компьютера, способного работать в сети. Из этого определения следует, что такие операционные системы, как, например, Windows NT, NetWare, Solaris, HP-UX, являются сетевыми, поскольку все они обладают средствами, которые позволяют их пользователям работать в сети.

См. также [ | ]

Примечания [ | ]

В недалеком прошлом под научные расчеты создавались специальные вычислительные кластеры, однако их мощность не безгранична и ее постоянно не хватает для обработки всех данных. Следовательно, ученым пришлось искать доступ к новым вычислительным ресурсам. Вместо покупки очередных дорогих компьютеров пошли альтернативным путем и начали использовать ПК обычных пользователей, которые те безвозмездно отдавали для расчетов во имя науки.

Сначала эта затея выглядела малоперспективной, ведь в середине девяностых, когда лишь начали появляться первые сети распределенных вычислений в их текущем виде, частота процессоров едва преодолела порог в 100 Мгц, Интернет был редкостью, а о доступе к действительно большому числу компьютеров не шло и речи.

Тем не менее, развитие Всемирной Сети и увеличение производительности процессоров в полном соответствии с законом Мура привело к тому, что сейчас распределенные сети на равных конкурируют с топовыми суперкомпьютерами, причем, в отличие от них, постоянно совершенствуются и не стоят ни копейки.

Если взглянуть на изменения в распределенных сетях за последние несколько лет, то можно сразу отметить несколько ключевых моментов.

Наверное, самым важным и пока еще не до конца раскрывшим себя шагом стал переход на GPU-вычисления, в некоторых случаях ускоряющий расчеты на порядок. Значительную роль сыграла и оптимизация вычислительных алгоритмов под многоядерные процессоры, возможность одновременного выполнения расчетов на CPU и GPU, поддержка 64-битных вычислений, появление клиентов для игровых консолей, поддержка альтернативных операционных систем (Mac OS X, Linux), быстрое распространение Интернета, и что немаловажно, заметное упрощение клиентов, которые больше не требуют от пользователей запуска вычислений через командную строку.

Сравнение с суперкомпьютерами

Сети распределенных вычислений уже называют виртуальными суперкомпьютерами, и приставка «виртуальные» здесь скорее используется для дифференциации от классических суперкомпьютеров, поскольку по скорости работы оба типа вычислительных систем находятся практически на одном уровне.

По состоянию на октябрь 2012 года проект Folding@home «завербовал» 219 тыс. процессоров, 20 тыс. GPU, 16 тыс. консолей PlayStation 3, и его суммарная мощность составила 3.7 petaFLOPS (пиковая мощность 6 petaFLOPS была зарегистрирована в ноябре 2011 г.). По данным за этот же месяц, производительность BOINC (всех проектов, входящих в состав этой сети) составляет 6.6 petaFLOPS (на момент публикации материала — 7.4 petaFLOPS, по данным официального сайта, но эта цифра подсчитывается лишь за последние 24 часа).

Если эти виртуальные вычислительные системы разместить в списке суперкомпьютеров, то они втиснутся между третьей и четвертой строчкой рейтинга, заметно опережая ближайшего конкурента (производительность SuperMUC, занимающего сейчас четвертое место, составляет 3.1 petaFLOPS).

Для того, чтобы подняться на первое место, Boinc необходимо быть быстрее приблизительно в три раза, поскольку рейтинг Sequoia (самого производительного на текущий момент суперкомпьютера в мире) составляет 20.1 petaFLOPS. Учитывая, что этот компьютер в полную мощность заработал лишь летом этого года, можно предположить, что распределенные вычислительные системы смогут вырваться вперед уже в течение нескольких лет, даже с учетом появления новых суперкомпьютеров.

Основные направления исследований

Без сомнения, распределенные вычисления уже стали распространенным феноменом, следовательно, среди них можно отыскать проекты, занимающиеся решением практически любых научных задач. Тем не менее, самые популярные проекты сконцентрированы на решении довольно узкого круга проблем. В первую очередь это медицина (исследование белков и поиск лекарств), предсказание климата, изучение космоса (поиск внеземных сигналов, правильных моделей вселенной, экзопланет), проверка математических и физических теорий.

Как подключиться к сети распределенных вычислений

Если вы решили, что поиск лекарств от неизлечимых пока болезней или предсказание изменения климата Земли – задачи, достойные того, чтобы выделить под них свой компьютер, то добровольно пожертвовать вычислительную мощность под любой из этих проектов совсем не сложно.

Проще всего это сделать, скачав клиент BOINC и запустив мастер добавления нового проекта. На одном из шагов необходимо будет зарегистрироваться (что можно сделать прямо в программе), вот и все трудности. Если возникли затруднения с выбором конкретного проекта, то можно указать сразу несколько, и они будут считаться по очереди.

По умолчанию BOINC использует компьютер все свободное время, однако выставляет для своих расчетов самый низкий приоритет, так что процессорные ресурсы используются клиентом в самую последнюю очередь.

Что касается памяти, то здесь понятие приоритета неприменимо, а поскольку на многоядерных процессорах BOINC запускает сразу несколько копий расчетов, каждая из которых может занимать в памяти несколько сотен мегабайт (такие объемы нужны не для всех проектов), то в играх и других требовательных приложениях все же лучше ставить расчеты на паузу, что можно сделать непосредственно в клиенте.

Более тонкую настройку можно провести в опциях BOINC, указав программе часы использования компьютера, период бездействия ПК, после которого можно запускать расчеты, а также количество процессорной мощности (в процентах), доступной клиенту.

Очки за участие

В большинстве проектов за участие начисляют очки. Их количество напрямую зависит от сложности расчетов, следовательно, чем производительнее компьютер и чем дольше он используется, тем больше очков начисляется. У каждого пользователя есть собственная страница со статистикой, где можно посмотреть личное и командное место в общем зачете (в качестве команды по умолчанию используется страна, указанная во время регистрации).

Boinc — это не распределенная сеть в традиционном понимании, а скорее посредник между проектами и пользователями. Изначально Boinc разрабатывался как клиент для SETI@home, но сейчас с его помощью можно подключиться и к десяткам других проектов.

Самый мощный проект по изучению климата Земли. Занимается моделированием погодных условий будущего (до 2080 года) с учетом различных входных данных. На текущий момент имеет в активе несколько миллионов просчитанных комбинаций. Проект был запущен в 2003 г.

Проект занимается поиском гравитационных волн, существование которых еще не доказано, но их наличие теоретически было предсказано Эйнштейном почти сто лет назад.

Для обнаружения гравитационных волн обрабатываются данные с радиотелескопов и специальных спутников, наблюдающих за вращающимися нейтронными звездами (пульсарами). За время существования проекта таких объектов было обнаружено более трех десятков.

Результаты проверки, опубликованные в июле 2012 г., свидетельствуют о том, что на текущий момент даже самые чувствительные датчики гравитационных волн не смогли зарегистрировать их наличие, но проект продолжает свою работу, анализируя новые данные и ожидая ввода в эксплуатацию более точных инструментов.

Einstein@home запущен в 2005 г. и на текущий момент его вычислительная мощность составляет приблизительно 0.5 petaFLOPS.

Один из наиболее популярных медицинских проектов, занимающихся виртуальным проектированием и изучением свойств новых протеинов, что может способствовать открытию лекарств от неизлечимых на данный момент болезней.

Проект запущен в 2005 г. и по состоянию на октябрь 2011 г. его вычислительная мощность составляла приблизительно 60 teraFLOPS (0.06 petaFLOPS)

Возможно, самый популярный проект распределенных вычислений. По вычислительной мощности уже сопоставим со всеми проектами, входящими в состав BOINC. Занимается практически тем же, что и Rosetta@home, т.е. изучением свойств белка, и с момента запуска благодаря ему были опубликованы более ста научных работ.

Большой мощности проект смог достичь как за счет раннего старта (2000 год), так и за счет выпуска очень производительного клиента для PlayStation 3 (2007 год), а также оптимизации расчетов под многоядерные процессоры и видеокарты, выполняющие вычисления, как правило, в несколько раз эффективнее самых современных CPU.

Один из ветеранов распределенных вычислений. Запущен в 1999 году, и таким образом, после десятилетий поиска внеземных сигналов в застенках научных лабораторий, к дешифровке космических радиоволн подключились и обычные компьютеры.

Несмотря на тринадцатилетний стаж, проект до сих пор не получил ни одного результата, сравнимого по скандальности с сигналом «Wow!» , зарегистрированном в 1975 г. Тем не менее, на небе было найдено несколько точек — кандидатов на более тщательное сканирование, в связи с повышенной интенсивностью сигналов на фоне обычного шума. Вычислительная мощность проекта составляет приблизительно 0.5 petaFLOPS.

Интересный проект, целью которого является создание поискового движка по принципу сетей распределенных вычислений.

Основная задача клиента, работающего на ПК, — индексирование страниц. В отличие от других типов распределенных вычислений, у Majestic-12 очень скромные требования к вычислительной мощности компьютера, но он очень интенсивно потребляет трафик.

По состоянию на октябрь 2009 Majestic-12 проиндексировал один триллион страниц. Google достиг той же цифры ненамного раньше — в июле 2008 года.

Проект предназначен для упрощения взлома паролей. Вместо того чтобы каждый раз перебирать миллионы комбинаций для одной конкретной последовательности символов, RainbowCrack генерирует хэши каждого пароля разными методами и сохраняет их в специальные таблицы, откуда по этому хэшу любой пароль можно получить гораздо быстрее.

На текущий момент таблицы RainbowCrack уже занимают сотни гигабайт и позволяют за несколько минут найти любой пароль длиной до семи символов (состоящий из букв, цифр и других символов), зашифрованный с помощью нескольких разных алгоритмов (LanMan, MD5, SHA1, и др.).

Проект создания искусственного интеллекта, способного воспринимать и обрабатывать информацию в языковой форме.

Проект все еще находится в стадии разработки и предназначен для поиска экзопланет, в том числе земного типа.

Проект поиска оптимальных стратегий обнаружения астероидов, проходящих вблизи от Земли.

Рендеринг 3D-анимации — весьма ресурсоемкая задача, поэтому и для нее нашлось место в распределенных вычислениях. Пока Burp находится в стадии Beta, а это значит, что сцены, загруженные для просчета, не обязательно будут выданы кому-то как задания, или могут быть выданы с задержкой, однако после полноценного запуска гарантируется рендеринг всех поступающих проектов.

Проект воссоздания трехмерной модели нашей Галактики, позволяющий узнать историю формирования Млечного Пути.

Помимо этого, просчитываются процессы столкновения и слияния Галактик.

Проект занимается созданием виртуальных моделей Вселенной и последующим сравнением их свойств со свойствами наблюдаемой Вселенной с целью поиска наиболее соответствующей модели. Полученные данные затем могут использоваться для планирования новых астрофизических исследований и экспериментов, а также для лучшей подготовки к анализу данных, поступающих от новейших космических миссий.

Проект занимается поиском наилучшего варианта органических молекул для создания нового типа солнечных панелей, а также оптимальных полимерных мембран для создания топливных батарей.

Как понятно из названия, эти, а также будущие задачи направлены на исследования альтернативных, экологически чистых источников энергии.

Проект по расчету магнитных конфигураций цилиндрических нано-элементов . Интересен тем, что это единственный проект столь высокого уровня, запущенный в Украине (разработан и поддерживается сотрудником Донецкого физико-технического института).

"Ну и что, что у меня Crysis не запускается", — с бесхитростной простотой признался мой друг Владимир, — "зато в 1974 году мой компьютер смог бы управлять эскадрой военных спутников!"

Я не стал возражать, мощность современных компьютеров доставляет удовольствие только производителям компьютерных игр и создателям монстроподобных операционных систем. 9 пользователей из 10 загружают процессор процентов на 40 в день. Всё остальное время – бессмысленное взбалтывания кулерами воздуха пока четырёхгигарцевый образец человеческого гения играет роль медиацентра.

Те, кого мучает совесть за нерациональное использование мощностей, организовали на нашей планете нечто вроде клуба любителей 100 процентного КПД ПК. Хакер проект SETI, от рака и СПИДа, а также множество других гуманных и нравственных проектов, включая получение наибольшего простого числа.

Предположим, в инопланетян вы до первого литра не верите, а лекарства считаете противными истинной сути «матери-природы». Более того, вам плевать даже на новые делители для чисел Ферма. Но не теряйте надежду. В мире существуют десятки других распределённых проектов, некоторые из которых разработаны хакерами для хакеров (RainbowCrack), предлагают вам неплохо заработать (GIMPS), а то и вовсе несут угрозу частичного вымирания человечества (LHC@home). Выбрать из них – лишь дело вкуса и ваших личных предпочтений.

Распределенные вычисления кажутся скучными играми математиков. До тех пор, пока кто-то не начинает считать на вашем компьютере модель локальной ядерной войны в странах третьего мира. Или разрабатывать новое бактериологическое оружие под видом лекарства от рака. Есть и очень популярные проекты, которые прямым текстом кричат «мы опасны!», но за общими словами создателей «ах, как это полезно и вы совсем ничего не теряете», трудно разглядеть истинные цели исследований. Знать заранее – и быть готовым к последствиям – ваша прямая обязанность. Иначе есть большой шанс, что миллионы леммингов сдвинут колесо истории в пропасть.

Climate Prediction

Проект, который пытается разбить на тысячу хрустящих осколков основы теории хаоса и предсказать погоду на 50 лет вперёд. Основываются предсказания не на «новых революционных методах прогнозирования, с использование суперкомпьютеров и магии индейских шаманов», а на самых что ни на есть старых теориях и схемах. То есть тем самым образом, каким погоду предсказывают и сейчас. Таким образом проект ставит перед собой 2 цели: во-первых, установить какова точность и эффективность используемых сейчас методик; во-вторых, если методики эффективны, предсказать погоду на наибольший период.

Участникам, как водится, придётся скачать программу, моделирующую различные погодные условия на Земле . Среди полученных результатов сначала отберут те, которые наиболее соответствуют результатам в прошлом, до 2000 года, и уже на их основе выстроят модель изменения климата в будущем.

Требования: во время работы программа занимает около 50 Мегабайт памяти, для сохранения данных потребуется 500 Мб на жёстком диске. В качестве бонуса отмечу интерактивность работы – вы сможете увидеть трёхмерную модель Земли и отследить своими глазами изменения в климате.

Результат: подобная задача у суперкомпьютера займёт тысячу лет, а ваше скромное участие через десяток лет поможет предсказывать различные зловредные погодные явления с невероятной точностью. Ну и к тому же вы похороните огромный раздел современной математики, утверждающий невозможность долгосрочных предсказаний.

LHC@home

Если вы торопитесь приблизить конец света на Земле – этот проект для вас. Проект занимается моделированием процессов, которые будут происходить в строящемся сейчас в Швейцарии LHC

(Large Hadron Collider

) — самом большом в мире ускорителе частиц . В ускорителе длиной около 27 километров планируют столкнуть два протона для того, чтобы экспериментально доказать существование некого бозона Хиггса. Некоторые специалисты и представители общественности высказывают опасения, что имеется отличная от нуля вероятность выхода проводимых в коллайдере экспериментов из-под контроля и развития цепной

реакции, которая при определённых условиях теоретически может уничтожить всю планету. Точка зрения сторонников катастрофических сценариев связанных с работой LHC

изложена на сайте http://www.risk-evaluation-forum.org/anon1.htm .

Считаете, что за дело аннигиляции всей вселенной можно и умереть – тогда присоединяйтесь. Дело в том, что от LHC ежегодно планируют получать до 15 петабайт данных. Уже сейчас вы можете помочь начать обрабатывать эти данные скачав программу SixTrack , которая моделирует движущиеся по кольцу в LHC частицы для изучения стабильности их орбит. Результаты выполнения программы SixTrack очень важны, от них зависит как будет работать крупнейший в мире научный проект, деятельность которого может совершить революцию в физике или отправить нашу галактику в антипространство.

Требования: несущественны.

Результат: доказательства некоторых научных теорий; низкоуровневый распад вселенной.

Muon1 Distributed Particle Accelerator Design

При маловероятном раскладе успешного испытания LHC , человечество непременно погубит Muon1 . К 2015 году планируется соорудить первую в мире The Neutrino Factory – лабораторию генерации частиц нейтрино . Нейтрино – самая распространённая частица во вселенной. Проникает практически через любые объекты без существенного снижения скорости. Известно, что через тело человека ежесекундно проскакивают 10 14 нейтрино. Понимание природы нейтрино даст человечеству ключ к разгадке истории возникновения всей вселенной.

Для генерации нейтрино планируется использовать мюонный колайдер — ускоритель, благодаря которому можно будет достичь самых высоких энергий столкновения частиц, когда-либо осуществлённых человеком. По сравнению с ним LHC – игрушка для детсадовца. Будет ли эффективна Muon1 и какие вообще результаты следует ожидать от нового колайдера решит ваш компьютер, если присоединится к проекту. Какими конкретно расчётами занимается клиентская программа понятно только специалисту в области квантовой физики. Однако не сомневайтесь – результаты очень важны.

Требования: Pentium III-500 c 64 МБ памяти.

Результат: возможно именно вы дадите толчок к финансированию одного из самых амбициозных проектов в истории человечества.

RainbowCrack

В то время как большинство проектов, связанных с компьютерной безопасностью, занимаются утомительными, едва ли не бессмысленными методами взлома шифровальных систем, RainbowCrack

создаёт базу по всем возможным видам паролей и соответствующим им хэшам по всем распространённым в мире алгоритмам хэширования. Обычно, хэшированный вариант пароля хранится в открытом доступе и известно, по какому алгоритму получен этот хэш (например MD5), но обратное преобразование считается слишком сложной операцией, требующей в общем случае перебор всех возможных комбинаций — это ставится в основу безопасности многих современных систем. Если же иметь сортированные таблицы хэшей и соответствующие им

пароли — получим систему, которая с помощью быстрого бинарного поиска по таблице может получать обратное преобразование хэша в пароль для любого существующего алгоритма хэширования.

Сейчас в проекте создано сотни гигабайт всех возможных паролей, которые позволяют с вероятностью порядка 99% найти за несколько минут обратное преобразование из хэша в любой пароль длиной до 7 символов (не только из букв, но также цифр и многих спец-символов), зашифрованных по алгоритмам LanMan (авторизация в Windows), NT LanMan (авторизация в Windows NT, в том числе сетевых доменах), MD2 , MD4 , MD5 , SHA1 , RIPEMD-160 , Cisco PIX (большинство маршрутизаторов), MySQL 3.23 , MySQL SHA1 .

Всем участникам проекта предоставляется возможность уже сейчас пользоваться полученной системой расшифровки паролей в виде онлайн-сервиса — частота использования сервиса одним участником неограниченна, но ограничено время действия каждого аккаунта. Для продления времени доступа участникам предлагается рассчитывать новые таблицы, увеличивающие количество поддерживаемых алгоритмов и комбинаций паролей. Обычно на расчёт таблицы уходит от нескольких дней до недели процессорного времени (2 ГГц) — за каждую таблицу время доступа продляется на 2 недели.

Требования: 640 Мегабайт на жёстком диске, исходящий трафик – около 3 Гигабайт в месяц. Почти не требует входящего трафика, процессорного времени или специфической оси.

Результат: редкий случай, когда работаете вы, скорее всего, на себя и результат используете в деле.

Здесь многие слышали о программе распределённых вычислений BOINC , возможно, многие даже принимают в нём участие. Эта статья рассчитана в первую очередь на тех, кто не слышал об этом проекте, но, может быть, заинтересуется им. Здесь я приведу краткие описания самых популярных проектов.

BOINC - программный комплекс для быстрой организации распределённых вычислений. Состоит из серверной и клиентской частей. Первоначально разрабатывался для крупнейшего проекта добровольных вычислений - SETI@home, но впоследствии разработчики из Калифорнийского университета в Беркли сделали платформу доступной для сторонних проектов. На сегодняшний день BOINC является универсальной платформой для проектов в области математики, молекулярной биологии, медицины, астрофизики и климатологии. BOINC даёт исследователям возможность задействовать огромные вычислительные мощности персональных компьютеров со всего мира .

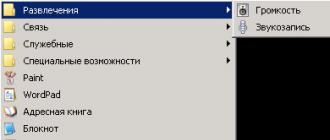

Кратко изобразить этот процесс можно так:

В данный момент в сети BOINC насчитывается около 300 тысяч активных участников, что в сумме даёт более 9 миллионов компьютеров и производительность более 8 петафлопс (на момент написания статьи).

Cosmology@Home

Проект направлен на поиски модели лучшим образом описывающую нашу Вселенную, и найти какая группа моделей подтверждает текущие данные, полученные теоретическими космологическими исследованиями и практическими физическими наблюдениями.